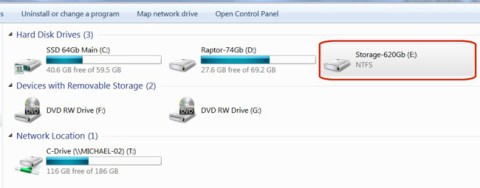

Jak odzyskać dostęp do dysku twardego, naprawić błąd uniemożliwiający otwarcie dysku twardego

W tym artykule pokażemy Ci, jak odzyskać dostęp do dysku twardego w przypadku awarii. Sprawdźmy!

Na początku kwietnia 2025 r. Meta wprowadziła na rynek Llama 4 , najnowszą serię modeli AI, które mają przenieść firmę na wyższy poziom. Każdy nowy model Llama 4 charakteryzuje się istotnymi udoskonaleniami w stosunku do swoich poprzedników. Oto najważniejsze nowości, które warto wypróbować.

3. Architektura Mieszanki Ekspertów (MoE)

Jedną z najbardziej charakterystycznych cech modeli Llama 4 jest nowa architektura MoE, po raz pierwszy w serii Llama, w której zastosowano inne podejście niż w poprzednich modelach. W nowej architekturze tylko niewielka część parametrów modelu jest aktywowana dla każdego tokena, w przeciwieństwie do tradycyjnych gęstych modeli transformatorowych, takich jak Llama 3 i starsze, gdzie wszystkie parametry są aktywowane dla każdego zadania.

Na przykład Llama 4 Maverick wykorzystuje tylko 17 miliardów aktywnych parametrów z 400 miliardów, przy czym korzysta ze 128 ekspertów kierowanych i jednego współdzielonego. Llama 4 Scout, najmniejsza z serii, ma łącznie 109 miliardów parametrów, z czego 16 ekspertów aktywuje tylko 17 miliardów.

Największa wersja tria, Llama 4 Behemoth, wykorzystuje 288 miliardów aktywnych parametrów (z 16 ekspertami) spośród łącznej liczby prawie dwóch bilionów parametrów. Dzięki tej nowej architekturze do każdego zadania przydzielanych jest tylko dwóch specjalistów.

Dzięki zmianie architektury modele w serii Llama 4 są bardziej wydajne obliczeniowo w trakcie treningu i wnioskowania. Włączenie tylko niewielkiej części parametrów zmniejsza koszty usługi i opóźnienia. Dzięki architekturze MoE, Meta twierdzi, że Llama może działać na pojedynczym procesorze graficznym Nvidia H100, co jest imponującym osiągnięciem, biorąc pod uwagę liczbę parametrów. Chociaż nie ma konkretnych danych na ten temat, uważa się, że każde zapytanie do ChatGPT wykorzystuje wiele procesorów graficznych Nvidia, co generuje większe obciążenie w niemal każdym mierzalnym parametrze.

2. Natywne możliwości przetwarzania multimodalnego

Kolejną ważną aktualizacją modeli sztucznej inteligencji Llama 4 jest natywne przetwarzanie multimodalne, co oznacza, że cała trójka jest w stanie jednocześnie rozumieć tekst i obrazy.

Jest to możliwe dzięki połączeniu wykonanemu w początkowej fazie szkolenia, gdzie tekst i tokeny wizualne są integrowane w ujednoliconą architekturę. Modele są trenowane przy użyciu dużych ilości nieoznakowanych danych tekstowych, graficznych i wideo.

Lepiej być nie może. Jeśli pamiętacie, aktualizacja Llama 3.2 firmy Meta , wydana we wrześniu 2024 r., wprowadziła szereg nowych modeli (w sumie 10), w tym 5 modeli widzenia multimodalnego i 5 modeli tekstowych. Dzięki tej generacji rozwiązań firma nie musi już udostępniać oddzielnych modeli tekstu i obrazu dzięki natywnym możliwościom przetwarzania multimodalnego.

Ponadto Llama 4 wykorzystuje udoskonalony koder wizualny, dzięki czemu modele mogą obsługiwać złożone zadania wnioskowania wizualnego i dane wejściowe obejmujące wiele obrazów. Dzięki temu są w stanie obsługiwać aplikacje wymagające zaawansowanej znajomości tekstu i obrazów. Przetwarzanie multimodalne pozwala na wykorzystanie modeli LLama 4 w wielu różnych aplikacjach.

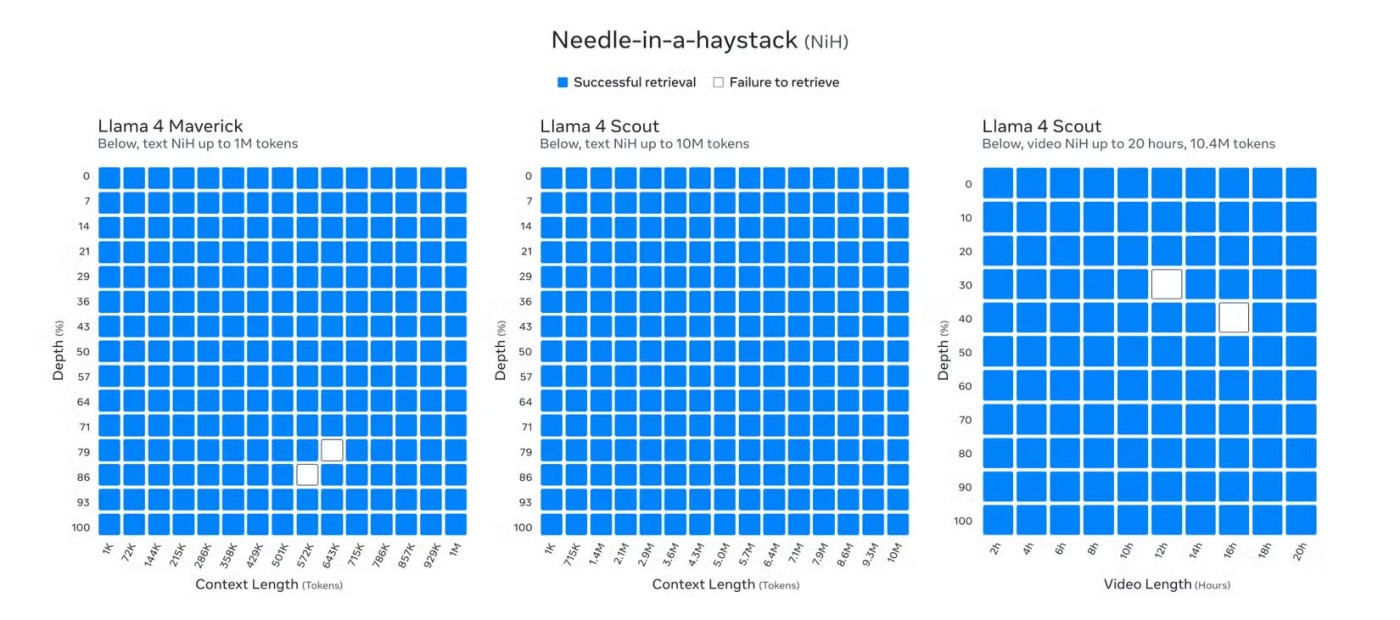

1. Wiodące w branży okno kontekstowe

Modele sztucznej inteligencji Llama 4 charakteryzują się niespotykanym dotąd kontekstowym oknem obejmującym aż 10 milionów tokenów. Chociaż w momencie publikacji gra Llama 4 Behemoth jest wciąż w fazie rozwoju, Llama 4 Scout wyznaczyła nowy standard branżowy dzięki swojej zdolności obsługi do 10 milionów tokenów w kontekście, co pozwala na wprowadzanie tekstu dłuższego niż 5 milionów słów.

Ta rozszerzona długość kontekstu stanowi znaczący wzrost w porównaniu do 8 tys. tokenów w Llama 3, gdy gra została po raz pierwszy wydana, a nawet późniejszego rozszerzenia do 128 tys. po aktualizacji Llama 3.2. Interesująca jest nie tylko długość kontekstu gry Llama 4 Scout, wynosząca 10 milionów; Nawet Llama 4 Maverick, z milionem kontekstów, jest imponującym osiągnięciem.

Llama 3.2 jest obecnie jednym z najlepszych chatbotów z AI do dłuższych konwersacji. Jednak rozszerzone okno kontekstowe Llama 4 stawia Llama na prowadzeniu, przewyższając poprzednie okno kontekstowe Gemini z 2 milionami najpopularniejszych tokenów, 200 tys. tokenów Claude 3.7 Sonnet i 128 tys. tokenów GPT-4.5.

Dzięki dużemu oknu kontekstowemu seria Llama 4 może obsługiwać zadania wymagające wprowadzania ogromnych ilości informacji. To duże okno przydaje się przy takich zadaniach, jak analiza długich, licznych dokumentów, szczegółowa analiza dużych baz kodów i wnioskowanie na dużych zbiorach danych.

Umożliwia także Llama 4 prowadzenie dłuższych konwersacji, w przeciwieństwie do poprzednich modeli Llama i modeli innych firm zajmujących się sztuczną inteligencją. Jeśli jednym z powodów, dla których Gemini 2.5 Pro jest najlepszym modelem wnioskowania, jest jego duże okno kontekstowe, to możesz sobie wyobrazić, jak potężne jest okno kontekstowe 5x lub 10x.

Modele lam z serii 3 firmy Meta należą do najlepszych modeli LLM na rynku. Jednak wraz z premierą serii Llama 4 firma Meta idzie o krok dalej, skupiając się nie tylko na poprawie wydajności wnioskowania (dzięki nowemu, wiodącemu w branży oknu kontekstowemu), ale także zapewniając możliwie najefektywniejsze modele dzięki wykorzystaniu nowej architektury MoE zarówno podczas treningu, jak i wnioskowania.

Natywne możliwości przetwarzania multimodalnego, wydajna architektura MoE i duże okno kontekstowe sprawiają, że Llama 4 jest otwartym, wydajnym, elastycznym modelem AI o dużej wadze, który może konkurować z wiodącymi modelami, a nawet je przewyższać w zakresie wnioskowania, kodowania i wielu innych zadań.

W tym artykule pokażemy Ci, jak odzyskać dostęp do dysku twardego w przypadku awarii. Sprawdźmy!

Na pierwszy rzut oka AirPodsy wyglądają jak każde inne prawdziwie bezprzewodowe słuchawki douszne. Ale wszystko się zmieniło, gdy odkryto kilka mało znanych funkcji.

Firma Apple wprowadziła system iOS 26 — dużą aktualizację z zupełnie nową obudową ze szkła matowego, inteligentniejszym interfejsem i udoskonaleniami znanych aplikacji.

Studenci potrzebują konkretnego typu laptopa do nauki. Powinien być nie tylko wystarczająco wydajny, aby dobrze sprawdzać się na wybranym kierunku, ale także kompaktowy i lekki, aby można go było nosić przy sobie przez cały dzień.

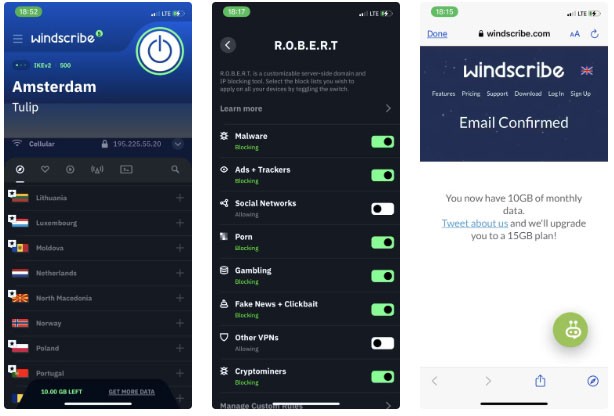

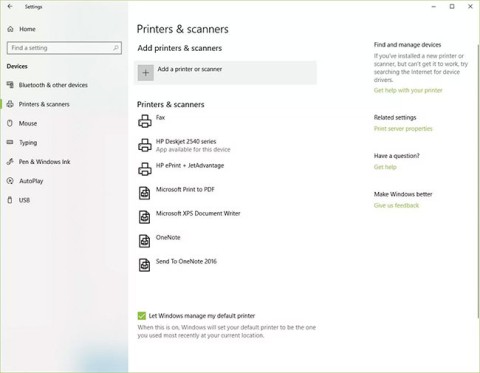

Dodanie drukarki do systemu Windows 10 jest proste, choć proces ten w przypadku urządzeń przewodowych będzie się różnić od procesu w przypadku urządzeń bezprzewodowych.

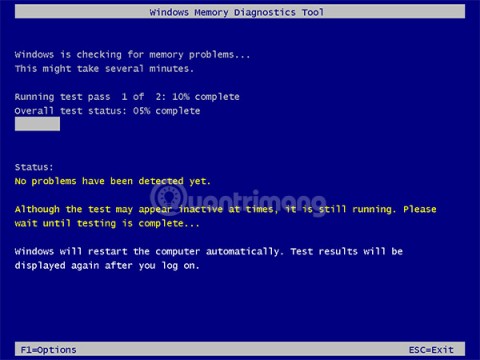

Jak wiadomo, pamięć RAM to bardzo ważny element sprzętowy komputera, który przetwarza dane i jest czynnikiem decydującym o szybkości laptopa lub komputera stacjonarnego. W poniższym artykule WebTech360 przedstawi Ci kilka sposobów sprawdzania błędów pamięci RAM za pomocą oprogramowania w systemie Windows.

Telewizory Smart TV naprawdę podbiły świat. Dzięki tak wielu świetnym funkcjom i możliwościom połączenia z Internetem technologia zmieniła sposób, w jaki oglądamy telewizję.

Lodówki to powszechnie stosowane urządzenia gospodarstwa domowego. Lodówki zazwyczaj mają dwie komory: komora chłodna jest pojemna i posiada światło, które włącza się automatycznie po każdym otwarciu lodówki, natomiast komora zamrażarki jest wąska i nie posiada światła.

Na działanie sieci Wi-Fi wpływa wiele czynników poza routerami, przepustowością i zakłóceniami. Istnieje jednak kilka sprytnych sposobów na usprawnienie działania sieci.

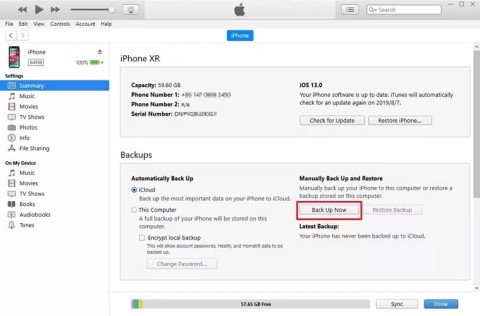

Jeśli chcesz powrócić do stabilnej wersji iOS 16 na swoim telefonie, poniżej znajdziesz podstawowy przewodnik, jak odinstalować iOS 17 i obniżyć wersję iOS 17 do 16.

Jogurt jest wspaniałym produktem spożywczym. Czy warto jeść jogurt codziennie? Jak zmieni się Twoje ciało, gdy będziesz jeść jogurt codziennie? Przekonajmy się razem!

W tym artykule omówiono najbardziej odżywcze rodzaje ryżu i dowiesz się, jak zmaksymalizować korzyści zdrowotne, jakie daje wybrany przez Ciebie rodzaj ryżu.

Ustalenie harmonogramu snu i rutyny związanej z kładzeniem się spać, zmiana budzika i dostosowanie diety to niektóre z działań, które mogą pomóc Ci lepiej spać i budzić się rano o odpowiedniej porze.

Proszę o wynajem! Landlord Sim to mobilna gra symulacyjna dostępna na systemy iOS i Android. Wcielisz się w rolę właściciela kompleksu apartamentowego i wynajmiesz mieszkania, a Twoim celem jest odnowienie wnętrz apartamentów i przygotowanie ich na przyjęcie najemców.

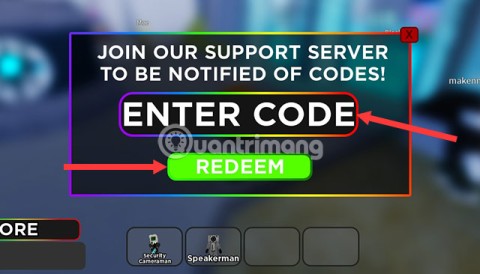

Zdobądź kod do gry Bathroom Tower Defense Roblox i wymień go na atrakcyjne nagrody. Pomogą ci ulepszyć lub odblokować wieże zadające większe obrażenia.