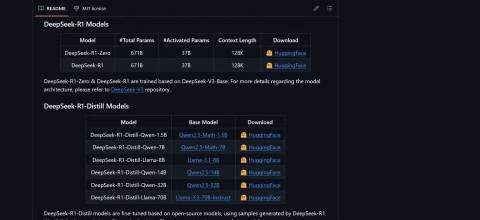

Chiński startup zajmujący się sztuczną inteligencją DeepSeek właśnie oficjalnie wydał swój najnowszy model języka dużego (LLM) o nazwie DeepSeek-V3-0324. Model ten, o pojemności do 641 GB, został zaprezentowany na platformie AI Hugging Face bez ujawniania zbyt wielu informacji, zgodnie z pełnym tajemnicy stylem, jaki firma do tej pory stosowała w odniesieniu do nowych produktów.

Cechą szczególną tego modelu jest licencja MIT, która pozwala na bezpłatne wykorzystanie w celach komercyjnych. Wstępne wyniki testów porównawczych pokazują, że DeepSeek-V3-0324 może działać na standardowych konfiguracjach sprzętowych, takich jak Mac Studio firmy Apple z procesorem M3 Ultra. Naukowiec zajmujący się sztuczną inteligencją Awni Hannun poinformował, że przy użyciu tej konfiguracji możliwe było osiągnięcie prędkości przetwarzania przekraczającej 20 tokenów na sekundę. Możliwość uruchamiania rozbudowanego modelu językowego na ogólnodostępnym sprzęcie lokalnym stoi w wyraźnym kontraście do tradycyjnego podejścia polegającego na wykorzystywaniu ogromnej infrastruktury centrów danych do obsługi zaawansowanych modeli sztucznej inteligencji.

Według informacji DeepSeek, wstępne testy wykazały znaczącą poprawę w stosunku do poprzednich wersji. Model ten został poddany rygorystycznym testom przez wewnętrznych interesariuszy i wykazał doskonałą wydajność, przewyższając nawet wszystkie inne konkurencyjne modele i model Claude Sonnet 3.5 firmy Anthropic w zadaniach niewymagających głębokiego myślenia. Jednak w przeciwieństwie do modeli w stylu Sonnet, które wymagają płatnej subskrypcji, DeepSeek-V3-0324 można pobrać i używać całkowicie bezpłatnie.

Technicznie rzecz biorąc, DeepSeek-V3-0324 wykorzystuje architekturę mieszanych ekspertów (MoE). Wyróżnia się zdolnością do selektywnego wykorzystywania około 37 miliardów z 685 miliardów parametrów na zadanie, co pozwala na zwiększenie efektywności poprzez redukcję wymagań obliczeniowych przy jednoczesnym zachowaniu wydajności. Model ten wykorzystuje również technologie Multi-Head Latent Attention (MLA) i Multi-Token Prediction (MTP), które przyczyniają się do ulepszenia pamięci kontekstowej i przyspieszenia wyników.

Użytkownicy mogą uzyskać dostęp do DeepSeek-V3-0324 za pośrednictwem Hugging Face, interfejsu czatu i API OpenRouter, a także, jeśli zajdzie taka potrzeba, platformy czatu DeepSeek. Dostęp do modelu zapewnia również dostawca usług wnioskowania Hyperbolic Labs.

Dzięki wydaniu DeepSeek-V3-0324 firma umacnia swoją pozycję w wyścigu o rozwój dużych modeli językowych, zapewniając jednocześnie potężne i dostępne rozwiązanie dla społeczności zajmującej się badaniami i rozwojem sztucznej inteligencji. Możliwość uruchomienia na powszechnie dostępnym sprzęcie i darmowa licencja z pewnością otworzą wiele możliwości praktycznego zastosowania tego modelu w niedalekiej przyszłości.