Gemma 2 czy Llama 3 to najlepszy model open source?

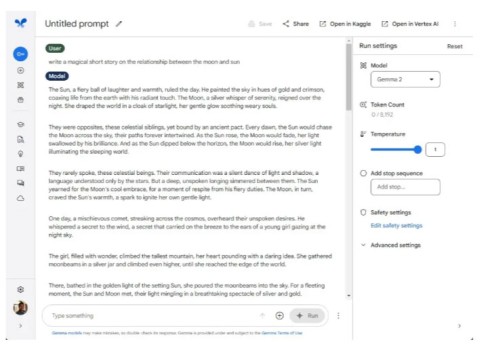

Mówi się, że nowy model Gemma 2 27B jest bardzo obiecujący i przewyższa niektóre większe modele, takie jak Llama 3 70B i Qwen 1.5 32B.

Llama 3 i GPT-4 to dwa najbardziej zaawansowane modele dużych języków (LLM) dostępne publicznie. Sprawdźmy, który model LLM jest lepszy, porównując oba modele pod względem multimodalności, długości kontekstu, wydajności i kosztów.

Spis treści

GPT-4 to najnowszy model języka dużego (LLM) opracowany przez OpenAI. Opiera się na fundamencie starszych modeli GPT-3, jednocześnie wykorzystując inne techniki treningowe i optymalizacyjne oraz wykorzystując znacznie większy zbiór danych. Znacznie zwiększyło to rozmiar parametrów GPT-4, który według plotek ma łącznie 1,7 biliona parametrów pochodzących z mniejszych modeli eksperckich. Dzięki nowym metodom szkoleniowym, optymalizacjom i większej liczbie parametrów GPT-4 zapewnia poprawę rozumowania, rozwiązywania problemów, rozumienia kontekstu i lepszego radzenia sobie ze niuansami instrukcji.

Obecnie dostępne są 3 warianty tego modelu:

Teraz możesz uzyskać dostęp do wszystkich trzech modeli GPT-4, subskrybując usługę API OpenAI, wchodząc w interakcję z ChatGPT lub za pośrednictwem usług takich jak Descript, Perplexity AI i wielu innych pomocniczych usług firmy Microsoft.

Llama 3 to oprogramowanie typu LLM typu open source opracowane przez Meta AI (spółkę macierzystą Facebooka, Instagrama i WhatsApp), które zostało wytrenowane przy użyciu kombinacji nadzorowanego dostrajania, próbkowania i optymalizacji zasad z wykorzystaniem zróżnicowanego zestawu danych, obejmującego miliony adnotacji wykonanych przez ludzi. Przykładowo program szkoleniowy skupia się na wysokiej jakości podpowiedziach i ustalaniu priorytetów, co ma na celu stworzenie elastycznego i wydajnego modelu sztucznej inteligencji.

Dostęp do Llama 3 można uzyskać za pośrednictwem Meta AI, generatywnego chatbota AI. Alternatywnie możesz uruchomić LLM lokalnie na swoim komputerze, pobierając modele Llama 3 i ładując je za pośrednictwem Ollama, Open WebUI lub LM Studio.

Wydanie GPT-4o przyniosło wreszcie wstępne informacje pokazujące, że GPT-4 jest multimodalny. Teraz możesz uzyskać dostęp do tych funkcji multimodalnych poprzez interakcję z ChatGPT przy użyciu modelu GPT-4o. Od czerwca 2024 r. GPT-4o nie ma wbudowanej funkcji generowania obrazu i dźwięku. Potrafi jednak generować tekst i obrazy na podstawie danych wejściowych wideo i audio.

Firma Llama 3 planuje również wprowadzenie modelu multimodalnego dla nadchodzącego modelu Llama 3 400B. Najprawdopodobniej zostaną w nim zintegrowane podobne technologie z CLIP (Contrast Language-Imager Pre-Training) w celu generowania obrazów przy użyciu technik Zero-shot Learning. Ponieważ jednak drukarka Llama 400B jest wciąż w fazie szkolenia, jedynym sposobem na generowanie obrazów przez modele 8B i 70B jest użycie rozszerzeń takich jak LLaVa, Visual-LLaMA i LLaMA-VID. Na chwilę obecną Llama 3 jest modelem bazującym wyłącznie na języku, który może przyjmować jako dane wejściowe tekst, obrazy i dźwięki w celu generowania tekstu.

Długość kontekstu odnosi się do ilości tekstu, jaką model może przetworzyć na raz. Jest to istotny czynnik, który należy wziąć pod uwagę przy rozważaniu możliwości modelu LLM, gdyż określa on, w jakim kontekście model może działać podczas interakcji z użytkownikiem. Ogólnie rzecz biorąc, większa długość kontekstu poprawia skuteczność LLM, ponieważ zapewnia wyższy poziom spójności i ciągłości, a także może ograniczyć powtarzanie błędów podczas interakcji.

|

Model |

Opis danych treningowych |

Parametry |

Długość kontekstu |

Jakość GQA |

Liczba żetonów |

Ograniczona wiedza |

|---|---|---|---|---|---|---|

|

Lama 3 |

Połącz publicznie dostępne dane online |

8B |

8 tys. |

Mieć |

15 ton+ |

Marzec 2023 |

|

Lama 3 |

Połącz publicznie dostępne dane online |

70B |

8 tys. |

Mieć |

15 ton+ |

Grudzień 2023 |

Modele Llama 3 mają efektywną długość kontekstu wynoszącą 8000 tokenów (około 6400 słów). Oznacza to, że model Llama 3 będzie miał pamięć kontekstową obejmującą około 6400 słów podczas interakcji. Każde słowo przekraczające limit 8000 znaczników zostanie zignorowane i nie będzie wnosiło żadnego dodatkowego kontekstu podczas interakcji.

|

Model |

Opisać |

Okno kontekstowe |

Dane treningowe |

|---|---|---|---|

|

GPT-4o |

Model multimodalny, tańszy i szybszy niż GPT-4 Turbo |

128 000 tokenów (API) |

Do października 2023 r. |

|

GPT-4-Turbo |

Model GPT-4 Turbo jest opływowy i zapewnia dobrą widoczność. |

128 000 tokenów (API) |

Do grudnia 2023 r. |

|

GPT-4 |

Pierwszy model GPT-4 |

8192 tokenów |

Do września 2021 r. |

Natomiast GPT-4 obsługuje teraz znacznie większe długości kontekstu, wynoszące 32 000 tokenów (około 25 600 słów) dla użytkowników ChatGPT i 128 000 tokenów (około 102 400 słów) dla użytkowników korzystających z punktu końcowego API. Dzięki temu model GPT-4 zyskuje przewagę w prowadzeniu dłuższych konwersacji i umożliwia czytanie długich dokumentów, a nawet całych książek.

Porównajmy wydajność, analizując raport testowy Llama 3 z 18 kwietnia 2024 r. opublikowany przez Meta AI oraz raport GitHub OpenAI z GPT-4 z 14 maja 2024 r. Oto wyniki:

|

Model |

MMLU |

Jakość GP |

MATEMATYKA |

Ocena człowieka |

UPUSZCZAĆ |

|---|---|---|---|---|---|

|

GPT-4o |

88,7 |

53,6 |

76,6 |

90,2 |

83,4 |

|

GPT-4 Turbo |

86,5 |

49.1 |

72.2 |

87,6 |

85,4 |

|

Lama3 8B |

68,4 |

34.2 |

30,0 |

62.2 |

58.4 |

|

Lama3 70B |

82,0 |

39,5 |

50,4 |

81,7 |

79,7 |

|

Lama3 400B |

86.1 |

48,0 |

57,8 |

84.1 |

83,5 |

Oto, co mierzy każde kryterium:

Najnowsze testy wydajności podkreślają różnice w wydajności między modelami GPT-4 i Llama 3. Podczas gdy model Llama 3 8B wydaje się znacznie gorszy, modele 70B i 400B osiągają gorsze, ale podobne wyniki do modeli GPT-4o i GPT-4 Turbo pod względem wiedzy akademickiej i ogólnej, czytania i rozumienia, rozumowania i logiki oraz kodowania. Jednakże żaden model Llama 3 nie osiągnął jeszcze wydajności GPT-4 w kategoriach czysto matematycznych.

Dla wielu użytkowników istotnym czynnikiem jest koszt. Model GPT-4o firmy OpenAI jest dostępny bezpłatnie dla wszystkich użytkowników ChatGPT z limitem 16 wiadomości co 3 godziny. Jeśli potrzebujesz więcej, musisz wykupić subskrypcję ChatGPT Plus za 20 USD miesięcznie, aby rozszerzyć limit wiadomości GPT-4o do 80 i uzyskać dostęp do dodatkowych modeli GPT-4.

Z drugiej strony, zarówno modele Llama 3 8B, jak i 70B są oparte na otwartym kodzie źródłowym i są bezpłatne, co może okazać się znaczącą zaletą dla deweloperów i badaczy poszukujących ekonomicznego rozwiązania bez uszczerbku dla wydajności.

Modele GPT-4 są szeroko dostępne za pośrednictwem generycznego chatbota AI ChatGPT firmy OpenAI i jego interfejsu API. GPT-4 można również używać w programie Microsoft Copilot, co stanowi sposób na bezpłatne korzystanie z GPT-4 . Szeroka dostępność sprawia, że użytkownicy mogą łatwo korzystać z jego możliwości w różnych przypadkach użycia. Z kolei Llama 3 jest projektem typu open source, który zapewnia elastyczność modelu i zachęca do szerszego eksperymentowania oraz współpracy w obrębie społeczności zajmującej się sztuczną inteligencją. To podejście oparte na otwartym dostępie może sprawić, że technologia sztucznej inteligencji stanie się bardziej dostępna dla szerszego grona odbiorców.

Chociaż dostępne są oba modele, GPT-4 jest znacznie łatwiejszy w użyciu, ponieważ jest zintegrowany z popularnymi narzędziami i usługami zwiększającymi produktywność. Z drugiej strony Llama 3 jest zintegrowana przede wszystkim z platformami badawczymi i biznesowymi, takimi jak Amazon Bedrock, Ollama i DataBricks (poza obsługą czatu Meta AI), co nie jest atrakcyjne dla szerszego rynku użytkowników nietechnicznych.

Który program LLM jest lepszy? GPT-4 jest lepszym LLM. GPT-4 wyróżnia się multimodalnością i zaawansowanymi możliwościami obsługi tekstu, obrazu i dźwięku, podczas gdy podobne funkcje Llama 3 są wciąż w fazie rozwoju. GPT-4 oferuje również znacznie większą długość kontekstu i lepszą wydajność, a ponadto jest szeroko dostępny za pośrednictwem popularnych narzędzi i usług, co sprawia, że GPT-4 jest bardziej przyjazny dla użytkownika.

Należy jednak podkreślić, że modele Llama 3 wypadły bardzo dobrze jak na projekt darmowy i open source. Dzięki temu Llama 3 pozostaje ważnym oprogramowaniem LLM, cenionym przez badaczy i przedsiębiorstwa za jego darmowy i otwarty charakter, a jednocześnie oferującym imponującą wydajność, elastyczność i niezawodne funkcje bezpieczeństwa. Choć przeciętny konsument może nie od razu znaleźć zastosowanie dla Llamy 3, dla wielu badaczy i przedsiębiorstw pozostaje ona najbardziej opłacalną opcją.

Podsumowując, podczas gdy GPT-4 wyróżnia się zaawansowanymi możliwościami multimodalnymi, większą długością kontekstu i bezproblemową integracją z powszechnie używanymi narzędziami, Llama 3 oferuje cenną alternatywę dzięki swojemu charakterowi open source, umożliwiając większą personalizację i redukcję kosztów. Jeśli chodzi o zastosowania, GPT-4 jest idealny dla tych, którzy szukają łatwości obsługi i kompleksowych funkcji w jednym modelu, natomiast Llama 3 doskonale sprawdzi się dla deweloperów i badaczy ceniących elastyczność i możliwość adaptacji.

Masz problem z logowaniem przez Internet w Microsoft Teams? Uzyskaj natychmiastowe rozwiązania typowych problemów, takich jak „Coś poszło nie tak” lub „Logowanie się zapętla”. Przewodnik krok po kroku, jak rozwiązać problemy z logowaniem przez Internet w Teams i zachować produktywność. Zaktualizowano o najnowsze poprawki przeglądarki.

Masz problem z błędem w samouczku Microsoft Teams? Odkryj proste rozwiązania krok po kroku, aby szybko go rozwiązać. Wyczyść pamięć podręczną, zaktualizuj i wiele więcej, aby zapewnić płynną pracę zespołową. Zaktualizowano do najnowszych wersji!

Masz dość błędów odtwarzania multimediów w Microsoft Teams, które psują Twoje spotkania w 2026 roku? Skorzystaj z naszego eksperckiego przewodnika krok po kroku, aby szybko naprawić błędy dźwięku, obrazu i udostępniania – bez konieczności posiadania umiejętności technicznych. Bezproblemowa współpraca czeka!

Masz problem z błędem proxy w Microsoft Teams? Poznaj sprawdzone sposoby rozwiązywania problemów z ustawieniami proxy w Microsoft Teams. Wyczyść pamięć podręczną, dostosuj ustawienia proxy i wróć do płynnych połączeń w kilka minut dzięki naszemu przewodnikowi eksperta.

Frustruje Cię pętla uruchamiania ekranu powitalnego w Microsoft Teams? Postępuj zgodnie ze sprawdzonymi krokami rozwiązywania problemów z pętlą uruchamiania ekranu powitalnego w Microsoft Teams: wyczyść pamięć podręczną, zresetuj aplikację, zainstaluj ponownie. Wróć do płynnej współpracy w kilka minut!

Frustruje Cię brak pokoi spotkań w Teams? Odkryj najczęstsze powody, dla których nie widzisz pokoi spotkań w Teams i postępuj zgodnie z naszymi krok po kroku, aby w kilka minut uruchomić je płynnie. Idealne rozwiązanie zarówno dla organizatorów, jak i uczestników!

Napotkałeś dziś błąd w Microsoft Teams? Ten przewodnik krok po kroku dotyczący rozwiązywania problemów z Microsoft Teams ujawnia pierwsze kroki, które pozwolą szybko go rozwiązać. Szybkie poprawki dotyczące łączności, pamięci podręcznej i aktualizacji, które pozwolą Ci bezproblemowo wrócić do czatowania.

Frustruje Cię brak dodatku Microsoft Teams w Outlooku? Odkryj najważniejsze przyczyny i proste rozwiązania krok po kroku, aby bezproblemowo przywrócić płynną integrację Teams z Outlookiem. Działa z najnowszymi wersjami!

Odblokuj dokładne lokalizacje kluczy rejestru Microsoft Teams w systemie Windows 11. Przewodnik krok po kroku, jak je znaleźć, uzyskać do nich dostęp i bezpiecznie je modyfikować, aby zapewnić optymalną wydajność i rozwiązywać problemy. Niezbędny dla specjalistów IT i entuzjastów Teams.

Masz dość błędów skrótów w Microsoft Teams, które blokują Twój przepływ pracy? Poznaj sprawdzone sposoby na rozwiązanie błędów skrótów i awarii uruchamiania Microsoft Teams, aby zapewnić płynną współpracę. Szybkie i proste rozwiązania w pakiecie!

Odblokuj dokładne miejsca, w których Microsoft Teams przechowuje nagrania w 2026 roku. Poznaj lokalizacje OneDrive i SharePoint, wskazówki dotyczące szybkiego dostępu i profesjonalne triki, aby bez problemu odnajdywać pliki. Nigdy więcej nie zgubisz nagrania ze spotkania!

Masz problem ze znalezieniem folderu instalacyjnego Microsoft Teams na swoim komputerze? Ten przewodnik krok po kroku ujawnia dokładne ścieżki dla nowych i klasycznych instalacji Teams, dla poszczególnych użytkowników i komputerów. Oszczędź czas na rozwiązywaniu problemów!

Masz dość zawieszania się Microsoft Teams z powodu poważnego błędu? Skorzystaj ze sprawdzonej poprawki rejestru 2026, która rozwiąże problem w kilka minut. Przewodnik krok po kroku, zrzuty ekranu i wskazówki, jak uzyskać trwałą ulgę. Działa w najnowszych wersjach!

Dowiedz się, gdzie dokładnie znajduje się kod QR Microsoft Teams, umożliwiający superszybkie logowanie mobilne. Przewodnik krok po kroku z wizualizacjami, dzięki któremu połączysz się w kilka sekund — bez konieczności podawania hasła!

Frustruje Cię status „Nieobecny” w Microsoft Teams? Odkryj najczęstsze przyczyny, takie jak limity czasu bezczynności i ustawienia zasilania, a także rozwiązania krok po kroku, aby szybko przywrócić stan „Dostępny”. Zaktualizowano o najnowsze funkcje Teams.