OpenAI wprowadza na rynek GPT-4o, obszerny multimodalny model językowy obsługujący rozmowy w czasie rzeczywistym, funkcję pytań i odpowiedzi, generowanie tekstu i wiele więcej.

OpenAI to jeden z dostawców, którzy ukształtowali erę generatywnej sztucznej inteligencji . Podstawą sukcesu i popularności OpenAI jest rodzina dużych modeli językowych (LLM) GPT firmy , obejmująca GPT-3 i GPT-4, a także usługa konwersacyjnej sztucznej inteligencji ChatGPT firmy .

Firma OpenAI ogłosiła, że GPT-4 Omni (GPT-4o) będzie nowym flagowym multimodalnym modelem językowym jej firmy. Miało to miejsce 13 maja 2024 r. podczas wydarzenia Spring Updates. W ramach wydarzenia firma OpenAI opublikowała szereg filmów prezentujących intuicyjne funkcje sprzężenia zwrotnego głosowego i możliwości wyjściowe tego modelu.

W lipcu 2024 OpenAI wypuściło mniejszą wersję GPT-4o — GPT-4o mini . Jest to najnowocześniejszy mały model tej firmy.

Czym jest GPT-4o?

GPT-4o to flagowy model w ofercie technologii LLM firmy OpenAI. O oznacza Omni i nie jest to tylko forma marketingowego szumu, ale raczej odnosi się do wielu sposobów wykorzystania tego modelu w zakresie tekstu, obrazów i dźwięku.

Model GPT-4o oznacza nową ewolucję modelu GPT-4 LLM, który OpenAI po raz pierwszy wydał w marcu 2023 r. Nie jest to jednak pierwsza aktualizacja modelu GPT-4, ponieważ model ten po raz pierwszy pojawił się w listopadzie 2023 r. wraz z wydaniem modelu GPT-4 Turbo. Skrót GPT oznacza Generative Pre-Trained Transformer. Model transformatora jest podstawowym elementem generatywnej sztucznej inteligencji, zapewniającym architekturę sieci neuronowej zdolną do rozumienia i generowania nowych wyników.

GPT-4o znacznie przewyższa GPT-4 Turbo pod względem możliwości i wydajności. Podobnie jak jego poprzednik GPT-4, GPT-4o można stosować w przypadkach, w których zachodzi potrzeba generowania tekstu, np. podsumowań oraz pytań i odpowiedzi opartych na wiedzy. Model ten jest również zdolny do rozumowania, rozwiązywania złożonych problemów i programowania.

Model GPT-4o wprowadza nową, szybką reakcję na sygnał audio, która — według OpenAI — jest podobna do ludzkiej, ze średnim czasem reakcji wynoszącym 320 milisekund. Model może również odpowiadać głosem generowanym przez sztuczną inteligencję, który brzmi jak głos ludzki.

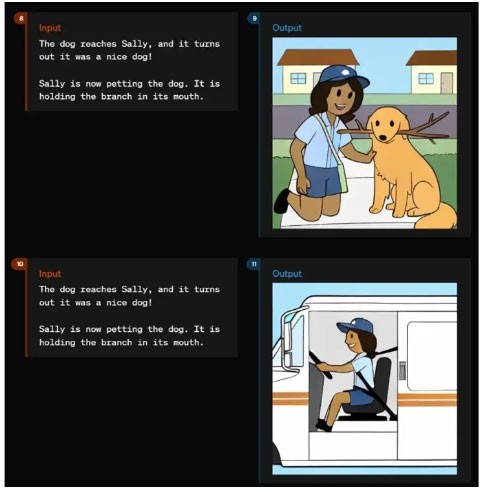

Zamiast oddzielnych modeli rozumiejących dźwięk, obrazy (które OpenAI nazywa wizją) i tekst, GPT-4o łączy te modalności w jeden model. Dzięki temu GPT-4o potrafi zrozumieć dowolną kombinację tekstu, obrazu i dźwięku i odpowiedzieć danymi wyjściowymi w dowolnej z tych form.

Technologia GPT-4o i jej możliwości przesyłania multimodalnego sprzężenia zwrotnego dźwięku o dużej prędkości mają umożliwić modelowi bardziej naturalne i intuicyjne interakcje z użytkownikami.

GPT-4o mini to najszybszy model OpenAI, który umożliwia tworzenie aplikacji przy niższych kosztach. GPT-4o mini jest inteligentniejszy niż GPT-3.5 Turbo i o 60% tańszy. Dane szkoleniowe będą dostępne do października 2023 r. GPT-4o mini jest dostępny w modelach tekstowym i wizualnym dla programistów za pośrednictwem interfejsu API asystentów, interfejsu API ukończeń czatu i interfejsu API wsadowego. Wersja mini jest również dostępna dla użytkowników ChatGPT, Free, Plus i Team.

Co potrafi GPT-4o?

W momencie premiery GPT-4o oferował najlepsze funkcje i wydajność spośród wszystkich modeli OpenAI.

GPT-4o potrafi m.in.:

- Interakcja w czasie rzeczywistym . Model GPT-4o umożliwia prowadzenie rozmów głosowych w czasie rzeczywistym bez zauważalnych opóźnień.

- Pytania i odpowiedzi oparte na wiedzy . Podobnie jak wszystkie poprzednie modele GPT-4, GPT-4o został wyszkolony z wykorzystaniem bazy wiedzy i potrafi odpowiadać na pytania.

- Podsumuj i wygeneruj tekst . Podobnie jak wszystkie poprzednie modele GPT-4, GPT-4o może wykonywać typowe zadania LLM związane z tekstem, w tym podsumowywanie i generowanie tekstu.

- Rozumowanie i generowanie multimodalne . GPT-4o integruje tekst, mowę i obrazy w jednym modelu, umożliwiając łączone przetwarzanie i reagowanie na różne typy danych. Model ten potrafi rozumieć dźwięk, obrazy i tekst z tą samą prędkością. Może również generować informacje zwrotne za pomocą dźwięku, obrazu i tekstu.

- Przetwarzanie języka i dźwięku . GPT-4o posiada zaawansowane możliwości obsługi ponad 50 różnych języków.

- Analiza sentymentu . Model ten analizuje nastroje użytkowników w kontekście różnych treści tekstowych, audio i wideo.

- Ton głosu . GPT-4o może generować głosy zawierające niuanse emocjonalne. Dzięki temu rozwiązanie to sprawdza się w aplikacjach wymagających wrażliwej i złożonej komunikacji.

- Analiza treści audio . Model ten potrafi generować i rozumieć język mówiony, co można wykorzystać w systemach aktywowanych głosem, analizie treści audio i interaktywnym opowiadaniu historii.

- Tłumaczenie w czasie rzeczywistym. Multimodalne możliwości GPT-4o pozwalają na tłumaczenie w czasie rzeczywistym z jednego języka na drugi.

- Zrozum obrazy i filmy. Model ten potrafi analizować obrazy i filmy, umożliwiając użytkownikom przesyłanie treści wizualnych, które GPT-4o może zrozumieć, zinterpretować i poddać analizie.

- Analiza danych . Możliwości wnioskowania i wizji pozwalają użytkownikom na analizowanie danych zawartych na wykresach danych. GPT-4o może również generować wykresy danych na podstawie analiz lub monitów.

- Prześlij plik. Oprócz progów wiedzy GPT-4o obsługuje przesyłanie plików, umożliwiając użytkownikom dostarczanie określonych danych do analizy.

- Świadomość kontekstowa i pamięć. GPT-4o potrafi zapamiętywać poprzednie interakcje i utrzymywać kontekst podczas długich konwersacji

- Duże okno kontekstowe . Dzięki oknu kontekstowemu obsługującemu do 128 000 tokenów, GPT-4o może zachować spójność długich konwersacji i dokumentów, co czyni go odpowiednim do szczegółowej analizy.

- Zmniejszenie halucynacji i poprawa bezpieczeństwa . Model ten ma na celu ograniczenie tworzenia niedokładnych lub wprowadzających w błąd informacji. GPT-4o obejmuje zaawansowane protokoły bezpieczeństwa, które gwarantują użytkownikom spójne i bezpieczne dane wyjściowe.

Jak używać GPT-4o

Użytkownicy i organizacje mogą wykorzystać GPT-4o na wiele sposobów.

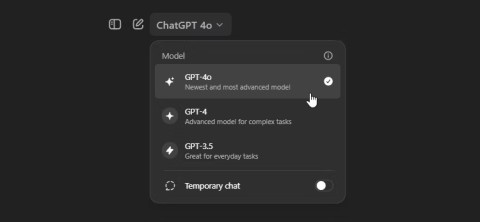

- ChatGPT jest bezpłatny. Model GPT-4o ma zostać udostępniony bezpłatnie użytkownikom chatbota ChatGPT firmy OpenAI. Gdy będzie to możliwe, GPT-4o zastąpi dotychczasowe ustawienie domyślne dla użytkowników ChatGPT Free. Bezpłatni użytkownicy ChatGPT będą mieli ograniczony dostęp do wiadomości i nie będą mogli korzystać z niektórych zaawansowanych funkcji, w tym przesyłania plików i analizy danych.

- ChatGPT Plus . Użytkownicy płatnej usługi ChatGPT firmy OpenAI otrzymają pełny dostęp do GPT-4o, bez ograniczeń funkcji dostępnych dla użytkowników bezpłatnych.

- Dostęp API . Programiści mogą uzyskać dostęp do GPT-4o poprzez API OpenAI. Umożliwia to integrację z aplikacjami, aby w pełni wykorzystać możliwości GPT-4o w zakresie zadań.

- Aplikacja desktopowa. Firma OpenAI zintegrowała GPT-4o z aplikacjami na komputery stacjonarne, w tym z nową aplikacją na system macOS firmy Apple, która została również wydana 13 maja.

- Niestandardowy GPT. Organizacje mogą tworzyć niestandardowe wersje GPT protokołu GPT-4o, aby spełnić określone potrzeby biznesowe lub działowe. Niestandardowe modele prawdopodobnie zostaną udostępnione użytkownikom za pośrednictwem sklepu GPT firmy OpenAI.

- Usługi Microsoft OpenAI. Użytkownicy mogą zapoznać się z możliwościami GPT-4o w trybie podglądu w programie Microsoft Azure OpenAI Studio, który został specjalnie zaprojektowany do obsługi danych wejściowych multimodalnych, w tym tekstu i obrazu. Ta pierwsza wersja umożliwia klientom usługi Azure OpenAI eksperymentowanie z możliwościami GPT-4o w kontrolowanym środowisku. W przyszłości planowane jest rozszerzenie tych możliwości.

Dodatkowo czytelnicy mogą zapoznać się z artykułem: Różnice pomiędzy GPT-4, GPT-4 Turbo i GPT-4o .