Firma OpenAI oficjalnie zaprezentowała trzy nowe modele: GPT-4.1, GPT-4.1 mini i GPT-4.1 nano. Modele te oferują ogromne możliwości przetwarzania kontekstu, sięgające nawet 1 miliona tokenów, oraz limity wiedzy aktualizowane do czerwca 2024 r.

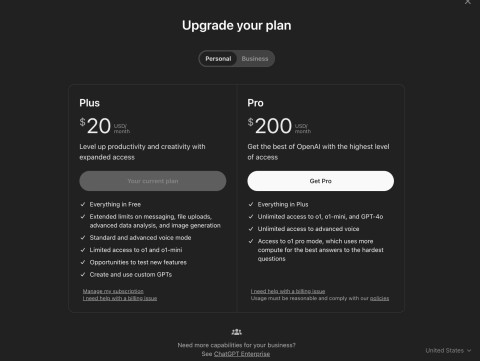

Firma twierdzi, że modele te oferują lepsze wyniki niż ostatnio ulepszone modele GPT-4o i GPT-4o mini, które wprowadzono na rynek w lipcu ubiegłego roku. Obecnie standard GPT-4.1 jest dostępny tylko za pośrednictwem interfejsu API, dlatego nie będzie można go jeszcze używać bezpośrednio w ChatGPT.

OpenAI zaznacza, że GPT-4.1 będzie dostępny wyłącznie poprzez API. W ChatGPT wiele udoskonaleń w zakresie zgodności instrukcji, programowania i inteligencji zostało stopniowo zintegrowanych z najnowszą wersją GPT-4o, a firma będzie nadal dodawać kolejne w przyszłych wydaniach.

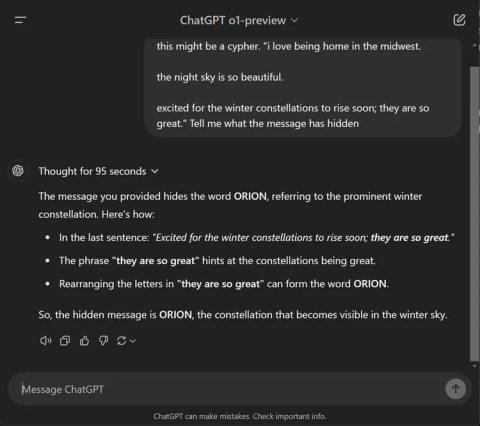

Testy porównawcze pokazują znaczące udoskonalenia wprowadzane przez GPT-4.1. Model ten uzyskał wynik 54,6% w teście SWE-bench Verified, co stanowi wzrost o 21,4 punktu w stosunku do GPT-4o. Model uzyskał wynik 38,3% w teście MultiChallenge — ocenie mierzącej przestrzeganie wytycznych — i ustanowił nowy rekord w zakresie rozumienia długich filmów, uzyskując wynik 72,0% w teście Video-MME, w którym modele analizują filmy trwające do godziny bez napisów.

OpenAI nawiązało również współpracę z partnerami alfa w celu przetestowania wydajności GPT-4.1 w rzeczywistych zastosowaniach.

- Thomson Reuters przetestował GPT-4.1 przy pomocy swojego asystenta prawnego CoCounsel, opartego na sztucznej inteligencji. W porównaniu z GPT-4o, GPT-4.1 odnotowuje 17% wzrost dokładności przy ocenie wielu dokumentów. Tego typu praca opiera się w dużej mierze na możliwości śledzenia kontekstu w wielu źródłach i identyfikowania złożonych powiązań, takich jak sprzeczne terminy lub ukryte zależności, a GPT-4.1 niezmiennie wykazuje wysoką wydajność.

- Carlyle użył GPT-4.1 do wyodrębnienia danych finansowych z długich i złożonych dokumentów, w tym plików Excel i PDF. Według wewnętrznych testów firmy, model ten działa o 50% lepiej niż poprzednie modele przy wyszukiwaniu dokumentów. Jest to pierwszy model, który niezawodnie radzi sobie z takimi problemami, jak szukanie „igły w stogu siana”, gubienie informacji w środku dokumentu i argumenty wymagające łączenia informacji w wielu plikach.

Wydajność to jedno, ale równie ważna jest szybkość. Według OpenAI GPT-4.1 zwraca pierwszy token w ciągu około 15 sekund przy przetworzeniu 128 000 tokenów, a w przypadku przetworzenia pełnego miliona tokenów – nawet w ciągu 30 sekund. GPT-4.1 mini i nano są jeszcze szybsze.

GPT-4.1 nano zazwyczaj odpowiada w czasie krótszym niż 5 sekund na monity zawierające 128 000 tokenów wejściowych. Szybkie buforowanie może dodatkowo zmniejszyć opóźnienia i obniżyć koszty.

Znaczący postęp nastąpił także w rozumieniu obrazu. W szczególności GPT-4.1 mini przewyższa GPT-4o w różnych testach wydajności wizualnej.

- W teście MMMU (obejmującym wykresy, diagramy i mapy) GPT-4.1 mini uzyskał wynik 73%. Jest to wynik wyższy niż GPT-4.5 i znacznie przewyższający 56% GPT-4o mini.

- W programie MathVista (który testuje zdolność rozwiązywania problemów z obrazami) zarówno GPT-4.1, jak i GPT-4.1 mini uzyskały 57%, co znacznie przewyższa wynik GPT-4o mini, który wyniósł 37%.

- W CharXiv-Reasoning , gdzie modele odpowiadają na pytania w oparciu o wykresy naukowe, GPT-4.1 nadal przoduje.

- W przypadku Video-MME (długie filmy bez napisów) GPT-4.1 osiągnął wynik 72%, co stanowi znaczną poprawę w porównaniu z wynikiem GPT-4o, który wyniósł 65%.

O cenie:

- GPT-4.1 kosztuje 2 dolary za 1 milion tokenów wejściowych i 8 dolarów za milion tokenów wyjściowych.

- Cena modułu GPT-4.1 mini wynosi 0,40 USD za wejście i 1,60 USD za wyjście.

- Koszt wejścia GPT-4.1 nano wynosi 0,10 USD, a wyjścia 0,40 USD.

Koszty te można dodatkowo obniżyć, korzystając z buforowania natychmiastowego lub interfejsu API wsadowego, co jest przydatne w przypadku aplikacji na dużą skalę. Firma OpenAI przygotowuje się również do zakończenia obsługi standardu GPT-4.5 Preview w dniu 14 lipca 2025 r., powołując się na lepszą wydajność, mniejsze opóźnienia i niższe koszty standardu GPT-4.1.